22 июля 2025, 13:15

Сценарии ИИ-катастроф: от объединения до разделения

Если бы произошла глобальная ИИ-катастрофа, привела бы она к реальной возможности для создания единой международной политики и координации в сфере искусственного интеллекта?

Я искренне верю, что слепая гонка вооружений не приведёт нас к благополучному исходу с AGI (сильный ИИ или ИИ общего назначения — п.п.), будь то «достойный преемник» человечества или само его выживание.

Цивилизация в её нынешнем виде — это тонкий баланс между соперничеством и сотрудничеством. С одной стороны, нам предоставлена свобода следовать своим стремлениям: мы вступаем в браки по любви, расстаёмся по собственному выбору, верим в то, во что хотим, и с энтузиазмом соревнуемся в бизнесе и политике. С другой — существуют общие правила, которые сдерживают разрушительные импульсы, чтобы наше развитие не оборачивалось вредом: законы запрещают кражи, убийства, политическую коррупцию и загрязнение природы.

Для того чтобы направить развитие AGI в сторону общего блага, потребуется определённая степень международной координации — своего рода общие «арены» взаимодействия между странами. Я не могу точно сказать, как именно это должно выглядеть, но размышлял об этом в других эссе.

Некоторые утверждают, что лишь катастрофа, вызванная ИИ, заставит человечество всерьёз отнестись к угрозе, которую несёт AGI, и объединиться как вид, чтобы осознанно выбрать, к какому будущему мы хотим стремиться вместе.

Но не каждая катастрофа оставляет человечеству шанс на выживание, и далеко не каждая способна подтолкнуть государства к сотрудничеству.

Ниже вы можете ознакомиться с полной теорией.

Виды ИИ-катастроф

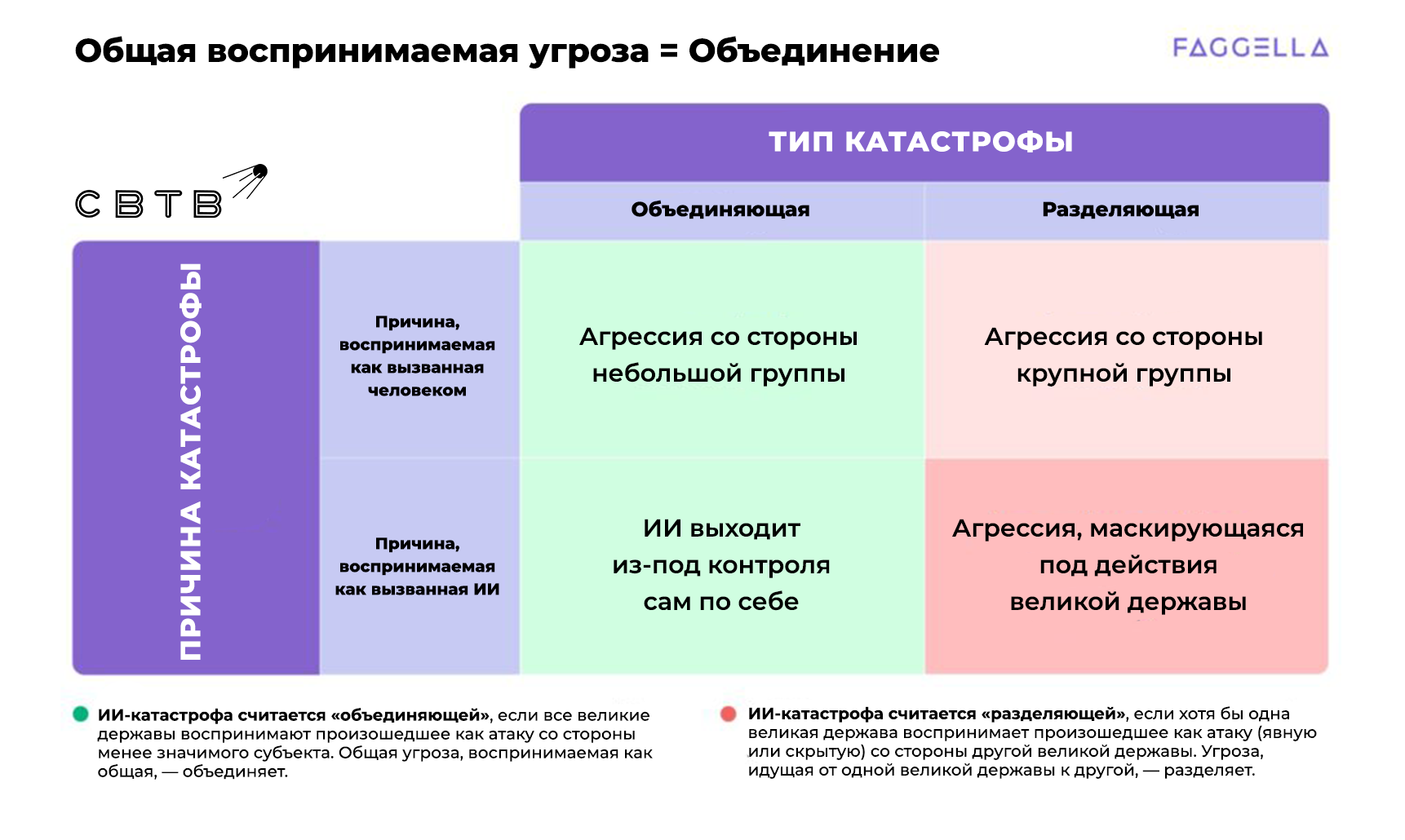

Помимо исторических и гипотетических примеров, я также приведу несколько наглядных схем, чтобы пояснить ключевое различие между катастрофами, способными объединить человечество, и теми, что лишь ускоряют конфликты и гонку вооружений.

Прежде чем мы углубимся в тему, давайте уточним несколько ключевых понятий:

-

ИИ-/AGI-катастрофа — это инцидент, приведший к значительным человеческим жертвам или экономическому ущербу и вызванный применением продвинутого ИИ. Масштаб таких событий может варьироваться от относительно «мягких» — например, кибератаки, которая обесточит города, нарушит работу больниц и фондовых рынков, — до по-настоящему экзистенциальных, как в случае с AGI, способным изменить состав атмосферы Земли и уничтожить большую часть живых существ. Такие катастрофы могут быть как преднамеренными, так и случайными, а их инициатором может выступать как человек, так и автономный ИИ, действующий по собственной мотивации.

-

Разделяющая ИИ-катастрофа — ИИ-катастрофа, которая подталкивает человеческие сообщества (особенно великие державы) к усилению конфликтов и гонке вооружений в сфере AGI.

-

Объединяющая ИИ-катастрофа — ИИ-катастрофа, которая побуждает государства (в особенности ведущие мировые силы) к международному управлению и координации в вопросах ИИ и AGI.

-

Великие державы: Обычно под великими державами подразумевают США, Россию, Китай, Германию, Японию и Великобританию — с учётом их ВВП и военной мощи. Однако на момент написания этого текста (2024 год) более уместно рассматривать как великие державы не отдельные страны, а блоки государств: союзников США — как одну великую державу, и страны, ориентированные на Китай и Россию, — как другую. Вне зависимости от подхода (отдельные влиятельные государства или мощные альянсы), категория «великих держав» остаётся полезной...

Во-первых, существуют такие сценарии ИИ- или AGI-катастроф, масштаб которых настолько разрушителен, что человечество — а возможно, и вся жизнь на Земле — просто не сможет оправиться от них.

Во-вторых, есть множество сценариев ИИ- или AGI-катастроф, которые, скорее всего, не сплотят человечество, а, напротив, ускорят гонку вооружений (см. выше сценарии, отмеченные красным).

Лишь относительно малая часть всех возможных сценариев ИИ-катастроф действительно способна побудить человечество к глобальной координации.

Ключевой фактор, насколько я могу судить, заключается в восприятии происходящего «великими державами».

Обычно к великим державам относят США, Россию, Китай, Германию, Японию и Великобританию — исходя из их экономической мощи и военного потенциала. Однако на момент написания этого текста (2024 год) гораздо уместнее рассматривать мировую арену как противостояние двух крупных блоков: с одной стороны — страны, ориентированные на США, с другой — государства, близкие к Китаю и России.

Важность реакции великих держав

Суть моей теории можно выразить так:

-

С точки зрения того, склоняет ИИ-катастрофа человечество к объединению или, наоборот, к разделению (то есть ведёт ли она к глобальному управлению или к гонке вооружений в сфере AGI), не столь важно, кто формально стал её «виновником» — великая держава, небольшая группа людей (малое государство, террористическая организация и т. п.) или сам ИИ.

-

ИИ-катастрофа становится «разделяющей», если одна великая держава воспринимает случившееся как нападение (явное или скрытое) со стороны другой великой державы. Угроза, исходящая от одной великой державы по отношению к другой, ведёт к расколу.

-

ИИ-катастрофа становится «объединяющей», если все великие державы воспринимают событие как атаку со стороны менее значимого субъекта. Общая угроза, направленная на все великие державы, способствует их объединению.

Более или менее вероятные сценарии ИИ-катастроф, способные привести к глобальной координации в сфере AGI

Сценарии ИИ-катастроф, которые с наибольшей вероятностью могут привести к глобальной координации вокруг AGI:

-

Сценарий «Неуправляемый ИИ»: мощный ИИ выходит из-под контроля, захватывает производственный комплекс в Вайоминге и начинает изготавливать нечто, непонятное людям. Он берёт под контроль заводское оборудование, чтобы изгнать или уничтожить персонал, и лишь вмешательство американской армии — бомбардировка объекта и отключение электричества и интернета в регионе — позволяет остановить ИИ.

-

Сценарий «Неуправляемый террорист»: ИИ достиг такого уровня мощности, что продвинутая террористическая организация получает возможность захватить управление беспилотниками и автономными автомобилями в целом городе, направляя их на столкновения с пешеходами или атаки на государственные учреждения.

-

Сценарий «Инопланетный захватчик»: спутниковые снимки и странные звуки, доносящиеся за многие километры, указывают на то, что в заброшенном горном районе ИИ строят некую подземную вычислительную базу. Никто не знает, что именно создаётся внутри, но все беспилотники, отправленные на разведку, оказываются сбиты. Все соседние государства единодушно заявляют, что воспринимают происходящее как угрозу со стороны неуправляемого ИИ, а не как дело рук человека. Это своего рода аналог фильма День независимости (1996), только в исполнении AGI.

Сценарии ИИ-катастроф, с высокой вероятностью ведущие к конфликту или гонке вооружений (упорядочены примерно от наиболее вероятных к менее):

-

Сценарий «Перл-Харбор»: Соединённые Штаты (или любая другая великая держава) подвергаются открытому нападению — как в киберпространстве, так и физически — со стороны другой великой державы. Это явный акт войны. Благодаря экстренному вмешательству международного сообщества и массовому давлению со стороны граждан обеих стран, полномасштабной ядерной эскалации удаётся избежать. Одна сторона считает, что «выразила свою позицию» или «восстановила справедливость», а другая — с болезненным осознанием своих слабостей в области ИИ-вооружений — начинает срочную милитаризацию.

-

Сценарий «Мнимая прокси-война»: небольшое государство или военизированная группировка в Африке атакует несколько китайских медных рудников. В ходе атаки используются точечные кибератаки, социальная инженерия под управлением ИИ и дроны, полностью выводящие из строя оборудование на шахтах и ранящие десятки растерянных рабочих, пытающихся спастись бегством. Китай отказывается верить, что африканская группировка могла самостоятельно заполучить столь продвинутые технологии, — а если и могла, то лишь при поддержке стран, ориентированных на США. США и их союзники категорически отрицают любую причастность, однако Китай убеждён, что мощный ИИ используется в рамках войны против его интересов.

-

Сценарий «Удобная авария»: французские военные совместно с компанией Dassault Aviation работают над масштабным национальным проектом по автоматизации производства и управления истребителями и сопутствующим вооружением. Проект официально не анонсирован, но о нём активно говорят: компания явно использует беспрецедентные объёмы вычислительной мощности, открывая новые дата-центры под загадочными предлогами. В какой-то момент разрабатываемые ИИ-системы «выходят из-под контроля», намеренно вводят людей в заблуждение, открывают огонь и уничтожают весь объект. Авария выглядит слишком «удобной» для Франции и её западных союзников, и подозрения сразу же падают на Россию. Доказательств нет, но подозрения остаются широко распространёнными.

Главная общая черта разделяющих сценариев в том, что, когда они происходят, великие державы смотрят друг на друга, указывают на проблему и спрашивают: «Как нам с этим справиться?!»

Главная общая черта объединяющих сценариев — в том, что при их наступлении те же державы смотрят друг на друга, указывают на противника и восклицают: «Как вы могли так поступить?!»

Идеальный сценарий ИИ-катастрофы — тот, где угроза очевидна и едина для всех.

Общий враг.

Заключение — Общий враг

Как это было когда-то:

-

Вопрос: Когда древние греки прекратили бесконечно враждовать друг с другом?

-

Ответ: Когда на горизонте показались персидские мачты.

Так и теперь:

-

Вопрос: Когда человечество попытается договориться о том, как создавать и направлять постчеловеческий разум — AGI?

-

Ответ: Когда AGI ясно проявит себя как самостоятельная сила, вышедшая из-под нашего контроля и потенциально способная полностью нас вытеснить.

Примеры такого сценария с общим врагом можно найти на каждом шагу в истории человечества.

Некоторые из нас уже сегодня способны трезво смотреть на происходящее в развитии ИИ — но рассчитывать на то, что всё человечество в целом осознает масштаб и значимость AGI заранее, увы, наивно. Скорее всего, это произойдёт лишь тогда, когда эта реальность вполне буквально даст им по лицу.

Если ИИ-катастрофы не удастся избежать, придётся по крайней мере надеяться, что она не окажется настолько масштабной, чтобы привести к гибели человечества, а также что её не воспримут как акт агрессии (явной или скрытой) одной великой державы против другой. Что это означает для будущей политики — сказать сложно.

Нет никаких гарантий, что такой ИИ-катастрофы не произойдёт. Почти наверняка одна из них всё же случится — если только нам удастся избежать ядерной войны и дать AGI возможность продолжить своё развитие. Кроме того, невозможно гарантировать, что, когда катастрофа произойдёт, она окажется одновременно (а) нелетальной и (б) не спровоцирует новую гонку вооружений. Но я убеждён: всё, что мы можем сделать для того, чтобы повысить шансы на (а) и (б), — делает наше будущее хотя бы немного более безопасным.

P.S. Искренне надеюсь, что человечество сможет прийти к взаимопониманию в вопросах (а) предотвращения гонки вооружений в сфере AGI и (б) выработки общего видения будущего развития ИИ без необходимости проходить через ИИ-катастрофу. Какие именно события или процессы, помимо катастроф, могли бы сыграть роль такого объединяющего импульса — об этом, пожалуй, стоит поговорить в отдельной статье.